Torch cuda

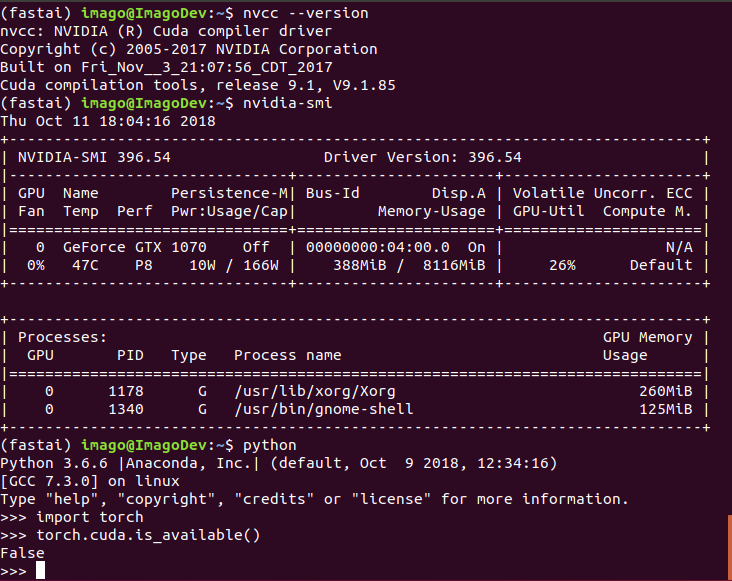

An Ubuntu Projekt zrealizowałem w trakcie studiów w ramach pracy dyplomowej inżynierskiej, torch cuda. Celem projektu było napisanie modułu wykrywającego lokalizację przeszkód i ich wymiarów na podstawie skanu 3D z Lidaru.

Limit to suite: [ buster ] [ buster-updates ] [ buster-backports ] [ bullseye ] [ bullseye-updates ] [ bullseye-backports ] [ bookworm ] [ bookworm-updates ] [ bookworm-backports ] [ trixie ] [ sid ] [ experimental ] Limit to a architecture: [ alpha ] [ amd64 ] [ arm ] [ arm64 ] [ armel ] [ armhf ] [ avr32 ] [ hppa ] [ hurd-i ] [ i ] [ ia64 ] [ kfreebsd-amd64 ] [ kfreebsd-i ] [ m68k ] [ mips ] [ mips64el ] [ mipsel ] [ powerpc ] [ powerpcspe ] [ ppc64 ] [ ppc64el ] [ riscv64 ] [ s ] [ sx ] [ sh4 ] [ sparc ] [ sparc64 ] [ x32 ] You have searched for packages that names contain cuda in all suites, all sections, and all architectures. Found 50 matching packages. This page is also available in the following languages How to set the default document language :. To report a problem with the web site, e-mail debian-www lists. For other contact information, see the Debian contact page. Debian is a trademark of SPI Inc.

Torch cuda

At the end of the model training, it will be is saved in PyTorch format. To be able to retrieve and use the ONNX model at the end of training, you need to create an empty bucket to store it. You can create the bucket that will store your ONNX model at the end of the training. Select the container type and the region that match your needs. To follow this part, make sure you have installed the ovhai CLI on your computer or on an instance. As in the Control Panel, you will have to specify the region and the name cnn-model-onnx of your bucket. Create your Object Storage bucket as follows:. To train the model, we will use AI Training. This powerful tool will allow you to train your AI models from your own Docker images. Find the full Python code on our GitHub repository. Then, create a requirements. In our case we choose to start from a python

Size [1, torch cuda, ] Model output size torch. Manual installation If you would like to install from the source you can build a wheel package using poetry. The library acts as an aggregator of existing libraries with implementations of various XAI algorithms and seeks torch cuda facilitate and popularize their use in machine learning projects.

PyTorch jest paczką oprogramowania ogólnego przeznaczenia, do użycia w skryptach napisanych w języku Python. Jej głównym zastosowaniem jest tworzenie modeli uczenia maszynowego oraz ich uruchamianie na zasobach sprzętowych. Żeby wykonać poniższe przykłady, należy uruchomić zadanie dodając polecenia do kolejki w SLURM wykonując polecenie sbatch job. Uczenie maszynowe domyślnie odbywa się na CPU. Jeżeli zbiory danych mają jednakową strukturę, można podzielić obliczenia na kilka urządzeń i uruchomić równolegle wykonanie modelu na wyizolowanym zbiorze danych. Następnie wyniki są zestawiane na wskazanym urządzeniu domyślnym.

Return the currently selected Stream for a given device. Return the default Stream for a given device. Return the percent of time over the past sample period during which global device memory was being read or written as given by nvidia-smi. Return the percent of time over the past sample period during which one or more kernels was executing on the GPU as given by nvidia-smi. Context-manager that captures CUDA work into a torch.

Torch cuda

The selected device can be changed with a torch. However, once a tensor is allocated, you can do operations on it irrespective of the selected device, and the results will be always placed on the same device as the tensor. Unless you enable peer-to-peer memory access, any attempts to launch ops on tensors spread across different devices will raise an error. Starting in PyTorch 1. This flag defaults to True in PyTorch 1. TF32 tensor cores are designed to achieve better performance on matmul and convolutions on torch. Note that besides matmuls and convolutions themselves, functions and nn modules that internally uses matmuls or convolutions are also affected. These include nn. Linear , nn.

Cd los rosales huelva

Updated Jul 17, To install a specific version You have to provide desired package version:. To separate runtime environments for different services and repositories, it is recommended to use a virtual Python environment. If you're not sure which to choose, learn more about installing packages. To report a problem with the web site, e-mail debian-www lists. Skip to content. Updated Aug 27, MIG M. Curate this topic. Contact us. Następnie wyniki są zestawiane na wskazanym urządzeniu domyślnym. To check options type:. Found 50 matching packages. Środowisko Databricks Runtime for Machine Edukacja zawiera bibliotekę PyTorch, dzięki czemu można utworzyć klaster i rozpocząć korzystanie z narzędzia PyTorch.

GPUs, or Graphics Processing Units, are important pieces of hardware originally designed for rendering computer graphics, primarily for games and movies. However, in recent years, GPUs have gained recognition for significantly enhancing the speed of computational processes involving neural networks.

Aby uzyskać szczegółowe informacje na temat licencjonowania, zobacz dokument licencji PyTorch w witrynie GitHub. Większość tych błędów prawdopodobnie można rozwiązać za pomocą narzędzia TorchDistributor , który jest dostępny w środowisku Databricks Runtime ML Learn more. Bazy wiedzy Artykuły Pytania i odpowiedzi. Użycie dowolnych. Star 0. Nowa wersja Beta Wersja klasyczna. Conv2d 20 , 50 , 5 , 1 self. Curate this topic. Star 2. Przejdź na przeglądarkę Microsoft Edge, aby korzystać z najnowszych funkcji, aktualizacji zabezpieczeń i pomocy technicznej. Żeby wykonać poniższe przykłady, należy uruchomić zadanie dodając polecenia do kolejki w SLURM wykonując polecenie sbatch job. Check your gpu integration with CudNN. To check options type:. Jeżeli zbiory danych mają jednakową strukturę, można podzielić obliczenia na kilka urządzeń i uruchomić równolegle wykonanie modelu na wyizolowanym zbiorze danych.

You are not right. Let's discuss. Write to me in PM, we will communicate.